- TERCER PARCIAL

- Equipo 1:

La Teoría Cuántica, una aproximación al universo probable

Es un conjunto de nuevas ideas que explican procesos incomprensibles para la física de los objetos

La Teoría Cuántica es uno de los pilares fundamentales de la Física actual. Recoge un conjunto de nuevas ideas introducidas a lo largo del primer tercio del siglo XX para dar explicación a procesos cuya comprensión se hallaba en conflicto con las concepciones físicas vigentes. Su marco de aplicación se limita, casi exclusivamente, a los niveles atómico, subatómico y nuclear, donde resulta totalmente imprescindible. Pero también lo es en otros ámbitos, como la electrónica, en la física de nuevos materiales, en la física de altas energías, en el diseño de instrumentación médica, en la criptografía y la computación cuánticas, y en la Cosmología teórica del Universo temprano. La Teoría Cuántica es una teoría netamente probabilista: describe la probabilidad de que un suceso dado acontezca en un momento determinado, sin especificar cuándo ocurrirá. A diferencia de lo que ocurre en la Física Clásica, en la Teoría Cuántica la probabilidad posee un valor objetivo esencial, y no se halla supeditada al estado de conocimiento del sujeto, sino que, en cierto modo, lo determina. Por Mario Toboso.

La Teoría Cuántica es uno de los pilares fundamentales de la Física actual. Se trata de una teoría que reúne un formalismo matemático y conceptual, y recoge un conjunto de nuevas ideas introducidas a lo largo del primer tercio del siglo XX, para dar explicación a procesos cuya comprensión se hallaba en conflicto con las concepciones físicas vigentes.

Las ideas que sustentan la Teoría Cuántica surgieron, pues, como alternativa al tratar de explicar el comportamiento de sistemas en los que el aparato conceptual de la Física Clásica se mostraba insuficiente. Es decir, una serie de observaciones empíricas cuya explicación no era abordable a través de los métodos existentes, propició la aparición de las nuevas ideas.

Hay que destacar el fuerte enfrentamiento que surgió entre las ideas de la Física Cuántica, y aquéllas válidas hasta entonces, digamos de la Física Clásica. Lo cual se agudiza aún más si se tiene en cuenta el notable éxito experimental que éstas habían mostrado a lo largo del siglo XIX, apoyándose básicamente en la mecánica de Newton y la teoría electromagnética de Maxwell (1865).

“Dos nubecillas”

Era tal el grado de satisfacción de la comunidad científica que algunos físicos, entre ellos uno de los más ilustres del siglo XIX, William Thompson (Lord Kelvin), llegó a afirmar:

Hoy día la Física forma, esencialmente, un conjunto perfectamente armonioso, ¡un conjunto prácticamente acabado! ... Aun quedan “dos nubecillas” que oscurecen el esplendor de este conjunto. La primera es el resultado negativo del experimento de Michelson-Morley. La segunda, las profundas discrepancias entre la experiencia y la Ley de Rayleigh-Jeans.

La disipación de la primera de esas “dos nubecillas” condujo a la creación de la Teoría Especial de la Relatividad por Einstein (1905), es decir, al hundimiento de los conceptos absolutos de espacio y tiempo, propios de la mecánica de Newton, y a la introducción del “relativismo” en la descripción física de la realidad. La segunda “nubecilla” descargó la tormenta de las primeras ideas cuánticas, debidas al físico alemán Max Planck (1900).

El origen de la Teoría Cuántica

¿Qué pretendía explicar, de manera tan poco afortunada, la Ley de Rayleigh-Jeans (1899)? Un fenómeno físico denominado radiación del cuerpo negro, es decir, el proceso que describe la interacción entre la materia y la radiación, el modo en que la materia intercambia energía, emitiéndola o absorbiéndola, con una fuente de radiación. Pero además de la Ley de Rayleigh-Jeans había otra ley, la Ley de Wien (1893), que pretendía también explicar el mismo fenómeno.

La Ley de Wien daba una explicación experimental correcta si la frecuencia de la radiación es alta, pero fallaba para frecuencias bajas. Por su parte, la Ley de Rayleigh-Jeans daba una explicación experimental correcta si la frecuencia de la radiación es baja, pero fallaba para frecuencias altas.

La frecuencia es una de las características que definen la radiación, y en general cualquier fenómeno en el que intervengan ondas. Puede interpretarse la frecuencia como el número de oscilaciones por unidad de tiempo. Toda la gama de posibles frecuencias para una radiación en la Naturaleza se hallan contenidas en el espectro electromagnético, el cual, según el valor de la frecuencia elegida determina un tipo u otro de radiación.

En 1900, Max Planck puso la primera piedra del edificio de la Teoría Cuántica. Postuló una ley (la Ley de Planck) que explicaba de manera unificada la radiación del cuerpo negro, a través de todo el espectro de frecuencias.

La hipótesis de Planck

¿Qué aportaba la ley de Planck que no se hallase ya implícito en las leyes de Wien y de Rayleigh-Jeans? Un ingrediente tan importante como novedoso. Tanto que es el responsable de la primera gran crisis provocada por la Teoría Cuántica sobre el marco conceptual de la Física Clásica. Ésta suponía que el intercambio de energía entre la radiación y la materia ocurría a través de un proceso continuo, es decir, una radiación de frecuencia f podía ceder cualquier cantidad de energía al ser absorbida por la materia.

Lo que postuló Planck al introducir su ley es que la única manera de obtener una fórmula experimentalmente correcta exigía la novedosa y atrevida suposición de que dicho intercambio de energía debía suceder de una manera discontinua, es decir, a través de la emisión y absorción de cantidades discretas de energía, que hoy denominamos “quantums” de radiación. La cantidad de energía E propia de un quantum de radiación de frecuencia f se obtiene mediante la relación de Planck: E = h x f, siendo h la constante universal de Planck = 6’62 x 10 (expo-34) (unidades de “acción”).

Puede entenderse la relación de Planck diciendo que cualquier radiación de frecuencia f se comporta como una corriente de partículas, los quantums, cada una de ellas transportando una energía E = h x f, que pueden ser emitidas o absorbidas por la materia.

La hipótesis de Planck otorga un carácter corpuscular, material, a un fenómeno tradicionalmente ondulatorio, como la radiación. Pero lo que será más importante, supone el paso de una concepción continuista de la Naturaleza a una discontinuista, que se pone especialmente de manifiesto en el estudio de la estructura de los átomos, en los que los electrones sólo pueden tener un conjunto discreto y discontinuo de valores de energía.

La hipótesis de Planck quedó confirmada experimentalmente, no sólo en el proceso de radiación del cuerpo negro, a raíz de cuya explicación surgió, sino también en las explicaciones del efecto fotoeléctrico, debida a Einstein (1905), y del efecto Compton, debida a Arthur Compton (1923).

Marco de aplicación de la Teoría Cuántica

El marco de aplicación de la Teoría Cuántica se limita, casi exclusivamente, a los niveles atómico, subatómico y nuclear, donde resulta totalmente imprescindible. Pero también lo es en otros ámbitos, como la electrónica (en el diseño de transistores, microprocesadores y todo tipo de componentes electrónicos), en la física de nuevos materiales, (semiconductores y superconductores), en la física de altas energías, en el diseño de instrumentación médica (láseres, tomógrafos, etc.), en la criptografía y la computación cuánticas, y en la Cosmología teórica del Universo temprano. De manera que la Teoría Cuántica se extiende con éxito a contextos muy diferentes, lo que refuerza su validez.

Pero, ¿por qué falla la teoría clásica en su intento de explicar los fenómenos del micromundo? ¿No se trata al fin y al cabo de una simple diferencia de escalas entre lo grande y lo pequeño, relativa al tamaño de los sistemas? La respuesta es negativa. Pensemos que no siempre resulta posible modelar un mismo sistema a diferentes escalas para estudiar sus propiedades.

Para ver que la variación de escalas es un proceso con ciertas limitaciones intrínsecas, supongamos que queremos realizar estudios hidrodinámicos relativos al movimiento de corrientes marinas. En determinadas condiciones, podríamos realizar un modelo a escala lo suficientemente completo, que no dejase fuera factores esenciales del fenómeno. A efectos prácticos una reducción de escala puede resultar lo suficientemente descriptiva.

Pero si reducimos la escala de manera reiterada pasaremos sucesivamente por situaciones que se corresponderán en menor medida con el caso real. Hasta llegar finalmente a la propia esencia de la materia sometida a estudio, la molécula de agua, que obviamente no admite un tratamiento hidrodinámico, y habremos de acudir a otro tipo de teoría, una teoría de tipo molecular. Es decir, en las sucesivas reducciones de escala se han ido perdiendo efectos y procesos generados por el aglutinamiento de las moléculas.

De manera similar, puede pensarse que una de las razones por las que la Física Clásica no es aplicable a los fenómenos atómicos, es que hemos reducido la escala hasta llegar a un ámbito de la realidad “demasiado esencial” y se hace necesario, al igual que en el ejemplo anterior, un cambio de teoría. Y de hecho, así sucede: la Teoría Cuántica estudia los aspectos últimos de la substancia, los constituyentes más esenciales de la materia (las denominadas “partículas elementales”) y la propia naturaleza de la radiación.

Las ideas que sustentan la Teoría Cuántica surgieron, pues, como alternativa al tratar de explicar el comportamiento de sistemas en los que el aparato conceptual de la Física Clásica se mostraba insuficiente. Es decir, una serie de observaciones empíricas cuya explicación no era abordable a través de los métodos existentes, propició la aparición de las nuevas ideas.

Hay que destacar el fuerte enfrentamiento que surgió entre las ideas de la Física Cuántica, y aquéllas válidas hasta entonces, digamos de la Física Clásica. Lo cual se agudiza aún más si se tiene en cuenta el notable éxito experimental que éstas habían mostrado a lo largo del siglo XIX, apoyándose básicamente en la mecánica de Newton y la teoría electromagnética de Maxwell (1865).

“Dos nubecillas”

Era tal el grado de satisfacción de la comunidad científica que algunos físicos, entre ellos uno de los más ilustres del siglo XIX, William Thompson (Lord Kelvin), llegó a afirmar:

Hoy día la Física forma, esencialmente, un conjunto perfectamente armonioso, ¡un conjunto prácticamente acabado! ... Aun quedan “dos nubecillas” que oscurecen el esplendor de este conjunto. La primera es el resultado negativo del experimento de Michelson-Morley. La segunda, las profundas discrepancias entre la experiencia y la Ley de Rayleigh-Jeans.

La disipación de la primera de esas “dos nubecillas” condujo a la creación de la Teoría Especial de la Relatividad por Einstein (1905), es decir, al hundimiento de los conceptos absolutos de espacio y tiempo, propios de la mecánica de Newton, y a la introducción del “relativismo” en la descripción física de la realidad. La segunda “nubecilla” descargó la tormenta de las primeras ideas cuánticas, debidas al físico alemán Max Planck (1900).

El origen de la Teoría Cuántica

¿Qué pretendía explicar, de manera tan poco afortunada, la Ley de Rayleigh-Jeans (1899)? Un fenómeno físico denominado radiación del cuerpo negro, es decir, el proceso que describe la interacción entre la materia y la radiación, el modo en que la materia intercambia energía, emitiéndola o absorbiéndola, con una fuente de radiación. Pero además de la Ley de Rayleigh-Jeans había otra ley, la Ley de Wien (1893), que pretendía también explicar el mismo fenómeno.

La Ley de Wien daba una explicación experimental correcta si la frecuencia de la radiación es alta, pero fallaba para frecuencias bajas. Por su parte, la Ley de Rayleigh-Jeans daba una explicación experimental correcta si la frecuencia de la radiación es baja, pero fallaba para frecuencias altas.

La frecuencia es una de las características que definen la radiación, y en general cualquier fenómeno en el que intervengan ondas. Puede interpretarse la frecuencia como el número de oscilaciones por unidad de tiempo. Toda la gama de posibles frecuencias para una radiación en la Naturaleza se hallan contenidas en el espectro electromagnético, el cual, según el valor de la frecuencia elegida determina un tipo u otro de radiación.

En 1900, Max Planck puso la primera piedra del edificio de la Teoría Cuántica. Postuló una ley (la Ley de Planck) que explicaba de manera unificada la radiación del cuerpo negro, a través de todo el espectro de frecuencias.

La hipótesis de Planck

¿Qué aportaba la ley de Planck que no se hallase ya implícito en las leyes de Wien y de Rayleigh-Jeans? Un ingrediente tan importante como novedoso. Tanto que es el responsable de la primera gran crisis provocada por la Teoría Cuántica sobre el marco conceptual de la Física Clásica. Ésta suponía que el intercambio de energía entre la radiación y la materia ocurría a través de un proceso continuo, es decir, una radiación de frecuencia f podía ceder cualquier cantidad de energía al ser absorbida por la materia.

Lo que postuló Planck al introducir su ley es que la única manera de obtener una fórmula experimentalmente correcta exigía la novedosa y atrevida suposición de que dicho intercambio de energía debía suceder de una manera discontinua, es decir, a través de la emisión y absorción de cantidades discretas de energía, que hoy denominamos “quantums” de radiación. La cantidad de energía E propia de un quantum de radiación de frecuencia f se obtiene mediante la relación de Planck: E = h x f, siendo h la constante universal de Planck = 6’62 x 10 (expo-34) (unidades de “acción”).

Puede entenderse la relación de Planck diciendo que cualquier radiación de frecuencia f se comporta como una corriente de partículas, los quantums, cada una de ellas transportando una energía E = h x f, que pueden ser emitidas o absorbidas por la materia.

La hipótesis de Planck otorga un carácter corpuscular, material, a un fenómeno tradicionalmente ondulatorio, como la radiación. Pero lo que será más importante, supone el paso de una concepción continuista de la Naturaleza a una discontinuista, que se pone especialmente de manifiesto en el estudio de la estructura de los átomos, en los que los electrones sólo pueden tener un conjunto discreto y discontinuo de valores de energía.

La hipótesis de Planck quedó confirmada experimentalmente, no sólo en el proceso de radiación del cuerpo negro, a raíz de cuya explicación surgió, sino también en las explicaciones del efecto fotoeléctrico, debida a Einstein (1905), y del efecto Compton, debida a Arthur Compton (1923).

Marco de aplicación de la Teoría Cuántica

El marco de aplicación de la Teoría Cuántica se limita, casi exclusivamente, a los niveles atómico, subatómico y nuclear, donde resulta totalmente imprescindible. Pero también lo es en otros ámbitos, como la electrónica (en el diseño de transistores, microprocesadores y todo tipo de componentes electrónicos), en la física de nuevos materiales, (semiconductores y superconductores), en la física de altas energías, en el diseño de instrumentación médica (láseres, tomógrafos, etc.), en la criptografía y la computación cuánticas, y en la Cosmología teórica del Universo temprano. De manera que la Teoría Cuántica se extiende con éxito a contextos muy diferentes, lo que refuerza su validez.

Pero, ¿por qué falla la teoría clásica en su intento de explicar los fenómenos del micromundo? ¿No se trata al fin y al cabo de una simple diferencia de escalas entre lo grande y lo pequeño, relativa al tamaño de los sistemas? La respuesta es negativa. Pensemos que no siempre resulta posible modelar un mismo sistema a diferentes escalas para estudiar sus propiedades.

Para ver que la variación de escalas es un proceso con ciertas limitaciones intrínsecas, supongamos que queremos realizar estudios hidrodinámicos relativos al movimiento de corrientes marinas. En determinadas condiciones, podríamos realizar un modelo a escala lo suficientemente completo, que no dejase fuera factores esenciales del fenómeno. A efectos prácticos una reducción de escala puede resultar lo suficientemente descriptiva.

Pero si reducimos la escala de manera reiterada pasaremos sucesivamente por situaciones que se corresponderán en menor medida con el caso real. Hasta llegar finalmente a la propia esencia de la materia sometida a estudio, la molécula de agua, que obviamente no admite un tratamiento hidrodinámico, y habremos de acudir a otro tipo de teoría, una teoría de tipo molecular. Es decir, en las sucesivas reducciones de escala se han ido perdiendo efectos y procesos generados por el aglutinamiento de las moléculas.

De manera similar, puede pensarse que una de las razones por las que la Física Clásica no es aplicable a los fenómenos atómicos, es que hemos reducido la escala hasta llegar a un ámbito de la realidad “demasiado esencial” y se hace necesario, al igual que en el ejemplo anterior, un cambio de teoría. Y de hecho, así sucede: la Teoría Cuántica estudia los aspectos últimos de la substancia, los constituyentes más esenciales de la materia (las denominadas “partículas elementales”) y la propia naturaleza de la radiación.

Albert Einstein

Cuándo entra en juego la Teoría Cuántica

Debemos asumir, pues, el carácter absoluto de la pequeñez de los sistemas a los que se aplica la Teoría Cuántica. Es decir, la cualidad “pequeño” o “cuántico” deja de ser relativa al tamaño del sistema, y adquiere un carácter absoluto. Y ¿qué nos indica si un sistema debe ser considerado “pequeño”, y estudiado por medio de la Teoría Cuántica? Hay una “regla”, un “patrón de medida” que se encarga de esto, pero no se trata de una regla calibrada en unidades de longitud, sino en unidades de otra magnitud física importante denominada “acción”.

La acción es una magnitud física, al igual que lo son la longitud, el tiempo, la velocidad, la energía, la temperatura, la potencia, la corriente eléctrica, la fuerza, etc., aunque menos conocida. Y al igual que la temperatura indica la cualidad de frío o caliente del sistema, y la velocidad su cualidad de reposo o movimiento, la acción indica la cualidad de pequeño (cuántico) o grande (clásico) del sistema. Como la energía, o una longitud, todo sistema posee también una acción que lo caracteriza.

Esta acción característica, A, se obtiene de la siguiente multiplicación de magnitudes: A = P x L, donde P representa la cantidad de movimiento característica del sistema (el producto de su masa por su velocidad) y L su “longitud” característica. La unidad de esa “regla” que mencionábamos, con la que medimos la acción de los sistemas, es la constante de Planck, h. Si el valor de la acción característica del sistema es del orden de la constante de Planck deberemos utilizar necesariamente la Teoría Cuántica a la hora de estudiarlo.

Al contrario, si h es muy pequeña comparada con la acción típica del sistema podremos estudiarlo a través de los métodos de la teoría clásica. Es decir: Si A es del orden de h debemos estudiar el sistema según la Teoría Cuántica. Si A es mucho mayor que h, podemos estudiarlo por medio de la Física Clásica.

Dos ejemplos: partículas y planetas

Veamos dos ejemplos de acción característica en dos sistemas diferentes, aunque análogos:

1. El electrón orbitando en torno al núcleo en el nivel más bajo de energía del átomo de hidrógeno.

Vamos a calcular el orden de magnitud del producto P x L. P representa el producto de la masa del electrón por su velocidad orbital, esto es P = 10 (exp-31) (masa) x 10 (exp 6) (velocidad) = 10 (exp-25) (cantidad de movimiento). El valor característico de L corresponde al radio de la órbita, esto es, L = 10 (expo-10) (longitud). Realizamos ahora el producto P x L para hallar la magnitud de la “acción” característica asociada a este proceso: A1 = Px L = 10 (expo-25) x 10 (expo-10) = 10 (expo-35) (acción).

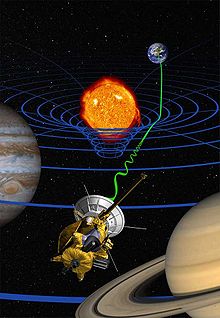

2. El planeta Júpiter orbitando en torno al Sol (consideramos la órbita circular, para simplificar).

Para este segundo ejemplo, realizamos cálculos análogos a los anteriores. Primeramente la cantidad de movimiento P, multiplicando la masa de Júpiter por su velocidad orbital: P = 10 (expo 26) (masa) x 10 (expo 4) (velocidad) = 10 (expo 30) (cantidad de movimiento). Igualmente, la longitud característica será la distancia orbital media: L = 10 (expo 11) (longitud). La magnitud de la acción característica en este segundo caso será: A2 = 10 (expo 30) x 10 (expo 11) = 10 (expo 41) (acción).

Si comparamos estos dos resultados con el orden de magnitud de la constante de Planck tenemos:

h = 10 (expo-34)

A1 = 10 (expo -35)

A2 = 10 (expo 41)

Vemos que para el caso 1 (electrón orbitando en un átomo de hidrógeno) la proximidad en los órdenes de magnitud sugiere un tratamiento cuántico del sistema, que debe estimarse como “pequeño” en el sentido que indicábamos anteriormente, en términos de la constante de Planck, considerada como “patrón” de medida. Al contrario, entre el caso 2 (Júpiter en órbita en torno al Sol) y la constante de Planck hay una diferencia de 75 órdenes de magnitud, lo que indica que el sistema es manifiestamente “grande”, medido en unidades de h, y no requiere un estudio basado en la Teoría Cuántica.

La constante de Planck tiene un valor muy, muy pequeño. Veámoslo explícitamente:

h = 0’ 000000000000000000000000000000000662 (unidades de acción)

El primer dígito diferente de cero aparece en la trigésimo cuarta cifra decimal. La pequeñez extrema de h provoca que no resulte fácil descubrir los aspectos cuánticos de la realidad, que permanecieron ocultos a la Física hasta el siglo XX. Allá donde no sea necesaria la Teoría Cuántica, la teoría clásica ofrece descripciones suficientemente exactas de los procesos, como en el caso del movimiento de los planetas, según acabamos de ver.

Debemos asumir, pues, el carácter absoluto de la pequeñez de los sistemas a los que se aplica la Teoría Cuántica. Es decir, la cualidad “pequeño” o “cuántico” deja de ser relativa al tamaño del sistema, y adquiere un carácter absoluto. Y ¿qué nos indica si un sistema debe ser considerado “pequeño”, y estudiado por medio de la Teoría Cuántica? Hay una “regla”, un “patrón de medida” que se encarga de esto, pero no se trata de una regla calibrada en unidades de longitud, sino en unidades de otra magnitud física importante denominada “acción”.

La acción es una magnitud física, al igual que lo son la longitud, el tiempo, la velocidad, la energía, la temperatura, la potencia, la corriente eléctrica, la fuerza, etc., aunque menos conocida. Y al igual que la temperatura indica la cualidad de frío o caliente del sistema, y la velocidad su cualidad de reposo o movimiento, la acción indica la cualidad de pequeño (cuántico) o grande (clásico) del sistema. Como la energía, o una longitud, todo sistema posee también una acción que lo caracteriza.

Esta acción característica, A, se obtiene de la siguiente multiplicación de magnitudes: A = P x L, donde P representa la cantidad de movimiento característica del sistema (el producto de su masa por su velocidad) y L su “longitud” característica. La unidad de esa “regla” que mencionábamos, con la que medimos la acción de los sistemas, es la constante de Planck, h. Si el valor de la acción característica del sistema es del orden de la constante de Planck deberemos utilizar necesariamente la Teoría Cuántica a la hora de estudiarlo.

Al contrario, si h es muy pequeña comparada con la acción típica del sistema podremos estudiarlo a través de los métodos de la teoría clásica. Es decir: Si A es del orden de h debemos estudiar el sistema según la Teoría Cuántica. Si A es mucho mayor que h, podemos estudiarlo por medio de la Física Clásica.

Dos ejemplos: partículas y planetas

Veamos dos ejemplos de acción característica en dos sistemas diferentes, aunque análogos:

1. El electrón orbitando en torno al núcleo en el nivel más bajo de energía del átomo de hidrógeno.

Vamos a calcular el orden de magnitud del producto P x L. P representa el producto de la masa del electrón por su velocidad orbital, esto es P = 10 (exp-31) (masa) x 10 (exp 6) (velocidad) = 10 (exp-25) (cantidad de movimiento). El valor característico de L corresponde al radio de la órbita, esto es, L = 10 (expo-10) (longitud). Realizamos ahora el producto P x L para hallar la magnitud de la “acción” característica asociada a este proceso: A1 = Px L = 10 (expo-25) x 10 (expo-10) = 10 (expo-35) (acción).

2. El planeta Júpiter orbitando en torno al Sol (consideramos la órbita circular, para simplificar).

Para este segundo ejemplo, realizamos cálculos análogos a los anteriores. Primeramente la cantidad de movimiento P, multiplicando la masa de Júpiter por su velocidad orbital: P = 10 (expo 26) (masa) x 10 (expo 4) (velocidad) = 10 (expo 30) (cantidad de movimiento). Igualmente, la longitud característica será la distancia orbital media: L = 10 (expo 11) (longitud). La magnitud de la acción característica en este segundo caso será: A2 = 10 (expo 30) x 10 (expo 11) = 10 (expo 41) (acción).

Si comparamos estos dos resultados con el orden de magnitud de la constante de Planck tenemos:

h = 10 (expo-34)

A1 = 10 (expo -35)

A2 = 10 (expo 41)

Vemos que para el caso 1 (electrón orbitando en un átomo de hidrógeno) la proximidad en los órdenes de magnitud sugiere un tratamiento cuántico del sistema, que debe estimarse como “pequeño” en el sentido que indicábamos anteriormente, en términos de la constante de Planck, considerada como “patrón” de medida. Al contrario, entre el caso 2 (Júpiter en órbita en torno al Sol) y la constante de Planck hay una diferencia de 75 órdenes de magnitud, lo que indica que el sistema es manifiestamente “grande”, medido en unidades de h, y no requiere un estudio basado en la Teoría Cuántica.

La constante de Planck tiene un valor muy, muy pequeño. Veámoslo explícitamente:

h = 0’ 000000000000000000000000000000000662 (unidades de acción)

El primer dígito diferente de cero aparece en la trigésimo cuarta cifra decimal. La pequeñez extrema de h provoca que no resulte fácil descubrir los aspectos cuánticos de la realidad, que permanecieron ocultos a la Física hasta el siglo XX. Allá donde no sea necesaria la Teoría Cuántica, la teoría clásica ofrece descripciones suficientemente exactas de los procesos, como en el caso del movimiento de los planetas, según acabamos de ver.

Breve cronología de la Teoría Cuántica

1900. “Hipótesis cuántica de Planck” (Premio Nobel de Física, 1918). Carácter corpuscular de la radiación.

1905. Einstein (Premio Nobel de Física, 1921) explica el “efecto fotoeléctrico” aplicando la hipótesis de Planck.

1911. Experimentos de Rutherford, que establecen el modelo planetario átomo, con núcleo (protones) y órbitas externas (electrones).

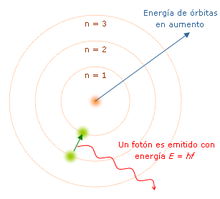

1913. Modelo atómico de Niels Bohr (Premio Nobel de Física, 1922). Tiene en cuenta los resultados de Rutherford, pero añade además la hipótesis cuántica de Planck. Una característica esencial del modelo de Bohr es que los electrones pueden ocupar sólo un conjunto discontinuo de órbitas y niveles de energía.

1923. Arthrur Comptom (Premio Nobel de Física, 1927) presenta una nueva verificación de la hipótesis de Planck, a través de la explicación del efecto que lleva su nombre.

1924. Hipótesis de De Broglie (Premio Nobel de Física, 1929). Asocia a cada partícula material una onda, de manera complementaria a cómo la hipótesis de Planck dota de propiedades corpusculares a la radiación.

1925. Werner Heisenberg (Premio Nobel de Física, 1932) plantea un formalismo matemático que permite calcular las magnitudes experimentales asociadas a los estados cuánticos.

1926. Erwin Schrödinger (Premio Nobel de Física, 1933) plantea la ecuación ondulatoria cuyas soluciones son las ondas postuladas teóricamente por De Broglie en 1924.

1927. V Congreso Solvay de Física, dedicado al tema “Electrones y fotones”. En él se produce el debate entre Einstein y Bohr, como defensores de posturas antagónicas, sobre los problemas interpretativos que plantea la Teoría Cuántica.

1928. Experimentos de difracción de partículas (electrones) que confirman la hipótesis de de Broglie, referente a las propiedades ondulatorias asociadas a las partículas. El fenómeno de difracción es propio de las ondas.

1932. Aparición del trabajo de fundamentación de la Teoría Cuántica elaborado por el matemático Jon von Neumann.

1900. “Hipótesis cuántica de Planck” (Premio Nobel de Física, 1918). Carácter corpuscular de la radiación.

1905. Einstein (Premio Nobel de Física, 1921) explica el “efecto fotoeléctrico” aplicando la hipótesis de Planck.

1911. Experimentos de Rutherford, que establecen el modelo planetario átomo, con núcleo (protones) y órbitas externas (electrones).

1913. Modelo atómico de Niels Bohr (Premio Nobel de Física, 1922). Tiene en cuenta los resultados de Rutherford, pero añade además la hipótesis cuántica de Planck. Una característica esencial del modelo de Bohr es que los electrones pueden ocupar sólo un conjunto discontinuo de órbitas y niveles de energía.

1923. Arthrur Comptom (Premio Nobel de Física, 1927) presenta una nueva verificación de la hipótesis de Planck, a través de la explicación del efecto que lleva su nombre.

1924. Hipótesis de De Broglie (Premio Nobel de Física, 1929). Asocia a cada partícula material una onda, de manera complementaria a cómo la hipótesis de Planck dota de propiedades corpusculares a la radiación.

1925. Werner Heisenberg (Premio Nobel de Física, 1932) plantea un formalismo matemático que permite calcular las magnitudes experimentales asociadas a los estados cuánticos.

1926. Erwin Schrödinger (Premio Nobel de Física, 1933) plantea la ecuación ondulatoria cuyas soluciones son las ondas postuladas teóricamente por De Broglie en 1924.

1927. V Congreso Solvay de Física, dedicado al tema “Electrones y fotones”. En él se produce el debate entre Einstein y Bohr, como defensores de posturas antagónicas, sobre los problemas interpretativos que plantea la Teoría Cuántica.

1928. Experimentos de difracción de partículas (electrones) que confirman la hipótesis de de Broglie, referente a las propiedades ondulatorias asociadas a las partículas. El fenómeno de difracción es propio de las ondas.

1932. Aparición del trabajo de fundamentación de la Teoría Cuántica elaborado por el matemático Jon von Neumann.

Aspectos esencialmente novedosos de la Teoría Cuántica

Los aspectos esencialmente novedosos (no clásicos) que se derivan de la Teoría Cuántica son:

a) Carácter corpuscular de la radiación (Hipótesis de Planck).

b) Aspecto ondulatorio de las partículas (Hipótesis de Broglie).

c) Existencia de magnitudes físicas cuyo espectro de valores es discontinuo. Por ejemplo los niveles de energía del átomo de hidrógeno (Modelo atómico de Bohr).

Implicaciones de a): carácter corpuscular de la radiación.

Tradicionalmente se había venido considerando la radiación como un fenómeno ondulatorio. Pero la hipótesis de Planck la considera como una corriente de partículas, “quantums”. ¿Qué naturaleza tiene, entonces, la radiación: ondulatoria o corpuscular? Las dos. Manifiesta un carácter marcadamente “dual”. Se trata de aspectos que dentro del formalismo cuántico no se excluyen, y se integran en el concepto de “quantum”.

El quantum de radiación puede manifestar propiedades tanto corpusculares como ondulatorias, según el valor de la frecuencia de la radiación. Para valores altos de la frecuencia (en la región gamma del espectro) predomina el carácter corpuscular. En tanto que para frecuencias bajas (en la región del espectro que describe las ondas de radio) predomina el aspecto ondulatorio.

Implicaciones de b): carácter ondulatorio de las partículas.

Se comprobó en experimentos de difracción de electrones y neutrones. Lo que ponen de manifiesto estos experimentos es que una clase de onda acompaña el movimiento de las partículas como responsable del fenómeno de difracción. De manera que nuevamente tenemos un ejemplo de dualidad entre las propiedades corpusculares y ondulatorias, asociadas en este caso a las partículas.

Pero la aparición del fenómeno ondulatorio no se produce únicamente a nivel microscópico, también se manifiesta para objetos macroscópicos, aunque en este caso la onda asociada tiene una longitud de onda tan pequeña que en la práctica es inapreciable y resulta imposible la realización de un experimento de difracción que la ponga de manifiesto.

Implicaciones de c): existencia de magnitudes físicas discontinuas.

Pone de manifiesto el carácter intrínsecamente discontinuo de la Naturaleza, lo que se evidencia, como ejemplo más notable, en el espectro de energía de los átomos. A partir de la existencia de estas discontinuidades energéticas se explica la estabilidad de la materia.

Los aspectos esencialmente novedosos (no clásicos) que se derivan de la Teoría Cuántica son:

a) Carácter corpuscular de la radiación (Hipótesis de Planck).

b) Aspecto ondulatorio de las partículas (Hipótesis de Broglie).

c) Existencia de magnitudes físicas cuyo espectro de valores es discontinuo. Por ejemplo los niveles de energía del átomo de hidrógeno (Modelo atómico de Bohr).

Implicaciones de a): carácter corpuscular de la radiación.

Tradicionalmente se había venido considerando la radiación como un fenómeno ondulatorio. Pero la hipótesis de Planck la considera como una corriente de partículas, “quantums”. ¿Qué naturaleza tiene, entonces, la radiación: ondulatoria o corpuscular? Las dos. Manifiesta un carácter marcadamente “dual”. Se trata de aspectos que dentro del formalismo cuántico no se excluyen, y se integran en el concepto de “quantum”.

El quantum de radiación puede manifestar propiedades tanto corpusculares como ondulatorias, según el valor de la frecuencia de la radiación. Para valores altos de la frecuencia (en la región gamma del espectro) predomina el carácter corpuscular. En tanto que para frecuencias bajas (en la región del espectro que describe las ondas de radio) predomina el aspecto ondulatorio.

Implicaciones de b): carácter ondulatorio de las partículas.

Se comprobó en experimentos de difracción de electrones y neutrones. Lo que ponen de manifiesto estos experimentos es que una clase de onda acompaña el movimiento de las partículas como responsable del fenómeno de difracción. De manera que nuevamente tenemos un ejemplo de dualidad entre las propiedades corpusculares y ondulatorias, asociadas en este caso a las partículas.

Pero la aparición del fenómeno ondulatorio no se produce únicamente a nivel microscópico, también se manifiesta para objetos macroscópicos, aunque en este caso la onda asociada tiene una longitud de onda tan pequeña que en la práctica es inapreciable y resulta imposible la realización de un experimento de difracción que la ponga de manifiesto.

Implicaciones de c): existencia de magnitudes físicas discontinuas.

Pone de manifiesto el carácter intrínsecamente discontinuo de la Naturaleza, lo que se evidencia, como ejemplo más notable, en el espectro de energía de los átomos. A partir de la existencia de estas discontinuidades energéticas se explica la estabilidad de la materia.

Dios no juega a los dados...

Un ejemplo concreto

Analicemos para el caso del átomo de hidrógeno, según el modelo de Bohr, cómo se conjugan estos tres supuestos cuánticos anteriores, a), b) y c). El átomo de hidrógeno se entiende como un sistema estable formado por un electrón y un protón. El electrón puede hallarse en un conjunto infinito, pero discontinuo de niveles de energía [supuesto c)].

Para pasar de un nivel a otro, el electrón debe absorber o emitir un quantum discreto de radiación [supuesto a)] cuya energía sea igual a la diferencia de energía entre esos niveles. Los niveles posibles de energía de los electrones se representan matemáticamente por funciones ondulatorias [supuesto b)], denominadas “funciones de estado”, que caracterizan el estado físico del electrón en el nivel de energía correspondiente.

Para conocer el valor experimental de cualquier propiedad referente a la partícula debe “preguntarse” a su función de estado asociada. Es decir, dicha función constituye un tipo de representación del estado físico, tal que el estado del electrón en el n-ésimo nivel de energía es descrito por la n-ésima función de estado.

La función de onda

La descripción más general del estado del electrón del átomo de hidrógeno viene dada por la “superposición” de diferentes funciones de estado. Tal superposición es conocida como “función de onda”. La superposición de estados posibles es típica de la Teoría Cuántica, y no se presenta en las descripciones basadas en la Física Clásica.

En esta última, los estados posibles nunca se superponen, sino que se muestran directamente como propiedades reales atribuibles al estado del sistema. Al contrario, especificar el estado del sistema en la Teoría Cuántica implica tomar en consideración la superposición de todos sus estados posibles. Las funciones de onda no son ondas asociadas a la propagación de ningún campo físico (eléctrico, magnético, etc.), sino representaciones que permiten caracterizar matemáticamente los estados de las partículas a que se asocian.

El físico alemán Max Born ofreció la primera interpretación física de las funciones de onda, según la cual el cuadrado de su amplitud es una medida de la probabilidad de hallar la partícula asociada en un determinado punto del espacio en un cierto instante. Aquí se manifiesta un hecho que se repetirá a lo largo del desarrollo de la Teoría Cuántica, y es la aparición de la probabilidad como componente esencial de la gran mayoría de los análisis.

La probabilidad en la Teoría Cuántica

La Teoría Cuántica es una teoría netamente probabilista. Nos habla de la probabilidad de que un suceso dado acontezca en un momento determinado, no de cuándo ocurrirá ciertamente el suceso en cuestión. La importancia de la probabilidad dentro de su formalismo supuso el punto principal de conflicto entre Einstein y Bohr en el V Congreso Solvay de Física de 1927.

Einstein argumentaba que la fuerte presencia de la probabilidad en la Teoría Cuántica hacía de ella una teoría incompleta reemplazable por una hipotética teoría mejor, carente de predicciones probabilistas, y por lo tantodeterminista. Acuñó esta opinión en su ya famosa frase, “Dios no juega a los dados con el Universo”.

La postura de Einstein se basa en que el papel asignado a la probabilidad en la Teoría Cuántica es muy distinto del que desempeña en la Física Clásica. En ésta, la probabilidad se considera como una medida de la ignorancia del sujeto, por falta de información, sobre algunas propiedades del sistema sometido a estudio. Podríamos hablar, entonces, de un valor subjetivo de la probabilidad. Pero en la Teoría Cuántica la probabilidad posee un valor objetivo esencial, y no se halla supeditada al estado de conocimiento del sujeto, sino que, en cierto modo, lo determina.

En opinión de Einstein, habría que completar la Teoría Cuántica introduciendo en su formalismo un conjunto adicional de elementos de realidad (a los que se denominó “variables ocultas”), supuestamente obviados por la teoría, que al ser tenidos en cuenta aportarían la información faltante que convertiría sus predicciones probabilistas en predicciones deterministas.

Analicemos para el caso del átomo de hidrógeno, según el modelo de Bohr, cómo se conjugan estos tres supuestos cuánticos anteriores, a), b) y c). El átomo de hidrógeno se entiende como un sistema estable formado por un electrón y un protón. El electrón puede hallarse en un conjunto infinito, pero discontinuo de niveles de energía [supuesto c)].

Para pasar de un nivel a otro, el electrón debe absorber o emitir un quantum discreto de radiación [supuesto a)] cuya energía sea igual a la diferencia de energía entre esos niveles. Los niveles posibles de energía de los electrones se representan matemáticamente por funciones ondulatorias [supuesto b)], denominadas “funciones de estado”, que caracterizan el estado físico del electrón en el nivel de energía correspondiente.

Para conocer el valor experimental de cualquier propiedad referente a la partícula debe “preguntarse” a su función de estado asociada. Es decir, dicha función constituye un tipo de representación del estado físico, tal que el estado del electrón en el n-ésimo nivel de energía es descrito por la n-ésima función de estado.

La función de onda

La descripción más general del estado del electrón del átomo de hidrógeno viene dada por la “superposición” de diferentes funciones de estado. Tal superposición es conocida como “función de onda”. La superposición de estados posibles es típica de la Teoría Cuántica, y no se presenta en las descripciones basadas en la Física Clásica.

En esta última, los estados posibles nunca se superponen, sino que se muestran directamente como propiedades reales atribuibles al estado del sistema. Al contrario, especificar el estado del sistema en la Teoría Cuántica implica tomar en consideración la superposición de todos sus estados posibles. Las funciones de onda no son ondas asociadas a la propagación de ningún campo físico (eléctrico, magnético, etc.), sino representaciones que permiten caracterizar matemáticamente los estados de las partículas a que se asocian.

El físico alemán Max Born ofreció la primera interpretación física de las funciones de onda, según la cual el cuadrado de su amplitud es una medida de la probabilidad de hallar la partícula asociada en un determinado punto del espacio en un cierto instante. Aquí se manifiesta un hecho que se repetirá a lo largo del desarrollo de la Teoría Cuántica, y es la aparición de la probabilidad como componente esencial de la gran mayoría de los análisis.

La probabilidad en la Teoría Cuántica

La Teoría Cuántica es una teoría netamente probabilista. Nos habla de la probabilidad de que un suceso dado acontezca en un momento determinado, no de cuándo ocurrirá ciertamente el suceso en cuestión. La importancia de la probabilidad dentro de su formalismo supuso el punto principal de conflicto entre Einstein y Bohr en el V Congreso Solvay de Física de 1927.

Einstein argumentaba que la fuerte presencia de la probabilidad en la Teoría Cuántica hacía de ella una teoría incompleta reemplazable por una hipotética teoría mejor, carente de predicciones probabilistas, y por lo tantodeterminista. Acuñó esta opinión en su ya famosa frase, “Dios no juega a los dados con el Universo”.

La postura de Einstein se basa en que el papel asignado a la probabilidad en la Teoría Cuántica es muy distinto del que desempeña en la Física Clásica. En ésta, la probabilidad se considera como una medida de la ignorancia del sujeto, por falta de información, sobre algunas propiedades del sistema sometido a estudio. Podríamos hablar, entonces, de un valor subjetivo de la probabilidad. Pero en la Teoría Cuántica la probabilidad posee un valor objetivo esencial, y no se halla supeditada al estado de conocimiento del sujeto, sino que, en cierto modo, lo determina.

En opinión de Einstein, habría que completar la Teoría Cuántica introduciendo en su formalismo un conjunto adicional de elementos de realidad (a los que se denominó “variables ocultas”), supuestamente obviados por la teoría, que al ser tenidos en cuenta aportarían la información faltante que convertiría sus predicciones probabilistas en predicciones deterministas.

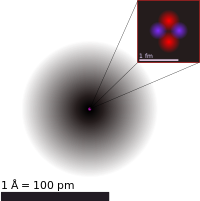

El modelo actual del átomo se basa en la mecánica cuántica ondulatoria, la cual está fundamentada en cuatro números cuánticos, mediante los cuales puede describirse un electrón en un átomo.

El desarrollo de está teoría durante la década de 1920 es el resultado de las contribuciones de destacados científicos entre ellos Einstein, Planck (1858-1947), de Broglie, Bohr (1885-1962), Schrödinger (1887-1961) y Heisenberg..

La siguiente figura muestra las modificaciones que ha sufrido el modelo del átomo desde Dalton hasta Schrödinger.

Teoría atómica

En química y física, la teoría atómica es una teoría científica sobre la naturaleza de la materia que sostiene que está compuesta de unidades discretas llamadas átomos. Empezó como concepto filosófico en la Antigua Grecia y logró amplia aceptación científica a principios del siglo XIX cuando descubrimientos en el campo de la química demostraron que la materia realmente se comportaba como si estuviese hecha de átomos.

La palabra átomo proviene del adjetivo en griego antiguo atomos, que significa "indivisible". Los químicos del siglo XIX empezaron a utilizar el término en relación con el número creciente de elementos químicos irreducibles.1 Mientras que alrededor del cambio al siglo XX, a través de varios experimentos con electromagnetismo y radiactividad, los físicos descubrieron que los "átomos indivisibles" eran de hecho un conglomerado de varias partículas subatómicas (principalmente, electrones, protones y neutrones), las que pueden existir separadas unas de otras. De hecho, en ciertos entornos extremos, como las estrellas de neutrones, la presión y la temperatura extremas impiden que los átomos puedan existir en absoluto. Ya que se descubrió que los átomos podían dividirse, los físicos inventaron el término "partículas elementales" para describir las partes "indivisibles", aunque no indestructibles, de un átomo. El campo de ciencia que estudia las partículas subatómicas es la física de partículas y es en este campo donde los físicos esperan descubrir la auténtica naturaleza fundamental de la materia.

Atomismo filosófico[editar]

La idea de que la materia está hecha de unidades discretas es una muy antigua y surge en muchas culturas antiguas como Grecia e India. No obstante, estas ideas estuvieron fundadas en el razonamiento filosófico y teológico más que en la evidencia y la experimentación. Como resultado, sus opiniones sobre cómo son los átomos y cómo se comportan eran muy incorrectas. Además no podían convencer a todo el mundo, así que el atomismo solo era una entre varias teorías rivales sobre la naturaleza de materia. No fue hasta el siglo XIX que los científicos abrazaron y refinaron la idea, ya que la floreciente ciencia de la química produjo descubrimientos que podían explicarse fácilmente utilizando el concepto del átomo.

Dalton[editar]

Cerca del fin del siglo XVIII, dos leyes sobre reacciones químicas emergieron sin referirse a la idea de una teoría atómica. La primera era la ley de conservación de masa, formulada por Antoine Lavoisier en 1789, la cual declara que la masa total permanece constante tras una reacción química (es decir, los reactantes tienen la misma masa que los productos).2 La segunda era la ley de proporciones definitivas. Probada originalmente por el farmacéutico francés Joseph Louis Proust en 1799, esta ley declara que si se descompone un compuesto en sus elementos constituyentes, entonces las masas de los elementos siempre tendrán las mismas proporciones, sin importar la cantidad o fuente de la sustancia original.3

John Dalton estudió y expandió este trabajo previo y desarrolló la ley de las proporciones múltiples: si dos elementos pueden combinarse para formar una cantidad de compuestos posibles, entonces las proporciones de las masas del segundo elemento que se combinan con una masa fija del primer elemento serán proporciones de números enteros pequeños. Por ejemplo: Proust había estudiado óxidos de estaño y descubrió que sus masas eran 88.1% estaño y 11.9% oxígeno o 78.7% estaño y 21.3% oxígeno (estos eran óxido de estaño (II) y dióxido de estaño respectivamente). Dalton notó en estos porcentajes que 100 g de estaño se combinará con 13,5 g o 27 g de oxígeno; 13,5 y 27 forman una proporción de 1:2. Dalton descubrió que una teoría atómica de la materia podría explicar elegantemente este patrón común en la química. En el caso de los óxidos de estaño de Proust, un átomo de estaño se combinará con uno o dos átomos de oxígeno.4

Dalton también creía que la teoría atómica podía explicar por qué el agua absorbió gases diferentes en proporciones diferentes. Por ejemplo, descubrió que el agua absorbiódióxido de carbono mucho mejor que el nitrógeno.5 Dalton hipotetizó que este se debió a las diferencias en masa y complejidad de las partículas de los gases respectivos. Ciertamente, las moléculas de dióxido de carbono (CO2) son más pesadas y grandes que las moléculas de nitrógeno (N2).

Propuso que cada elemento químico está compuesto de átomos de un solo tipo solo y aunque estos no pueden ser alterados o destruidos por medios químicos, pueden combinarse para formar estructuras más complejas (compuestos químicos). Esto marca la primera teoría verdaderamente científica del átomo, ya que Dalton logró sus conclusiones por experimentación y examen de los resultados de forma empírica.

En 1803 presentó su primera lista de pesos atómicos relativos para un número de sustancias. Este artículo se publicó en 1805, pero en él Dalton no analizó exactamente cómo obtuvo esas cifras.5 El método fue revelado en 1807 por su conocido Thomas Thomson, en la tercera edición del libro de Thomson, Un Sistema de Química. Finalmente, Dalton publicó una explicación completa en su propio texto,Un Nuevo Sistema de Filosofía Química (1808 y 1810).

Dalton estimó los pesos atómicos según las proporciones de masa en que se combinan, tomando al átomo de hidrógeno la unidad. Sin embargo, Dalton no concibió que con algunos elementos los átomos existen en moléculas, por ejemplo el oxígeno puro existe como O2. También creyó erróneamente que el compuesto más sencillo entre dos elementos cualesquiera es siempre un átomo de cada uno (así que pensó que el agua era HO, no H2O).6 Esto, sumado a la crudeza de su equipamiento, malogró sus resultados. Por ejemplo, en 1803 creía que los átomos de oxígeno eran 5,5 veces más pesados que los átomos de hidrógeno, porque en el agua midió 5,5 gramos de oxígeno por cada gramo de hidrógeno y creía que la fórmula para el agua era HO. Con datos mejores, en 1806 concluyó que el peso atómico del oxígeno de hecho debía ser 7 en vez de 5,5, y mantuvo este peso por el resto de su vida. Otros en estos tiempos ya habían concluido que el átomo de oxígeno tiene que pesar 8 átomos de hidrógeno si uno supone la fórmula de Dalton para la molécula de agua (HO), o 16 si uno supone la fórmula moderna (H2O).7

Avogadro[editar]

El defecto en la teoría de Dalton fue corregida en principio en 1811 por Amedeo Avogadro. Avogadro había propuesto que volúmenes iguales de cualesquier dos gases, en presión y temperatura iguales, contienen números iguales de moléculas (en otras palabras, la masa de las partículas de un gas no afecta el volumen que ocupa).8 La ley de Avogadro le permitió deducir la naturaleza diatómica de numerosos gases al estudiar los volúmenes en los que reaccionan. Por ejemplo: ya que dos litros de hidrógeno reaccionarán con un único litro de oxígeno para producir dos litros de vapor de agua (en temperatura y presión constantes), significa que una sola molécula de oxígeno se divide en dos para formar dos partículas de agua. De este modo Avogadro fue capaz de ofrecer estimaciones más precisas de la masa atómica del oxígeno y varios otros elementos e hizo una distinción clara entre moléculas y átomos.

Movimiento browniano[editar]

En 1827, el botánico británico Robert Brown observó que las partículas de polvo dentro de los granos de polen que flotan en el agua constantemente vibran sin razón aparente. En 1905, Albert Einstein teorizó que este movimiento browniano era causado por el continuo golpeteo de las moléculas de agua y desarrolló un modelo matemático para describirlo.9 En 1908 el físico francés Jean Perrin la validó experimentalmente, lo que proveyó de validación adicional a la teoría particular (y por extensión a la teoría atómica).

Descubrimiento de las partículas subatómicas[editar]

Hasta 1897, se creía que los átomos eran la división más pequeña de la materia, cuando J.J Thomson descubrió el electrón mediante su experimento con el tubo de rayos catódicos.10 El tubo de rayos catódicos que usó Thomson era un recipiente cerrado de vidrio, en el cual los dos electrodos estaban separados por un vacío. Cuando se aplica una diferencia de tensión a los electrodos, se generan rayos catódicos, que crean un resplandor fosforescente cuando chocan con el extremo opuesto del tubo de cristal. Mediante la experimentación, Thomson descubrió que los rayos se desviaban al aplicar un campo eléctrico (además de desviarse con los campos magnéticos, cosa que ya se sabía). Afirmó que estos rayos, más que ondas, estaban compuestos por partículas cargadas negativamente a las que llamó "corpúsculos" (más tarde, otros científicos las rebautizarían como electrones).

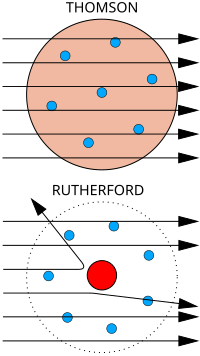

Thomson creía que los corpúsculos surgían de los átomos del electrodo. De esta forma, estipuló que los átomos eran divisibles, y que los corpúsculos eran sus componentes. Para explicar la carga neutra del átomo, propuso que los corpúsculos se distribuían en estructuras anilladas dentro de una nube positiva uniforme; este era el modelo atómico de Thomson o "modelo del plum cake".11

Ya que se vio que los átomos eran realmente divisibles, los físicos inventaron más tarde el término "partículas elementales" para designar a las partículas indivisibles.

Descubrimiento del núcleo[editar]

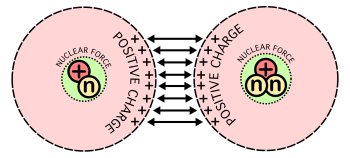

El modelo atómico de Thomson fue refutado en 1909 por uno de sus estudiantes, Ernest Rutherford, quien descubrió que la mayor parte de la masa y de la carga positiva de un átomo estaba concentrada en una fracción muy pequeña de su volumen, que suponía que estaba en el mismo centro.

En su experimento, Hans Geiger y Ernest Marsden bombardearon partículas alfa a través de una fina lámina de oro (que chocarían con unapantalla fluorescente que habían colocado rodeando la lámina).12 Dada la mínima como masa de los electrones, la elevada masa y momento de las partículas alfa y la distribución uniforme de la carga positiva del modelo de Thomson, estos científicos esperaban que todas las partículas alfa atravesasen la lámina de oro sin desviarse, o por el contrario, que fuesen absorbidas. Para su asombro, una pequeña fracción de las partículas alfa sufrió una fuerte desviación. Esto indujo a Rutherford a proponer el modelo planetario del átomo, en el que los electrones orbitaban en el espacio alrededor de un gran núcleo compacto, a semejanza de los planetas y el Sol.13

Descubrimiento de los isótopos[editar]

En 1913, Thomson canalizó una corriente de iones de neón a través de campos magnéticos y eléctricos, hasta chocar con una placa fotográfica que había colocado al otro lado. Observó dos zonas incandescentes en la placa, que revelaban dos trayectorias de desviación diferentes. Thomson concluyó que esto era porque algunos de los iones de neón tenían diferentes masas; así fue como descubrió la existencia de los isótopos.14

Descubrimiento del neutrón[editar]

Véase también: Neutrón#Historia

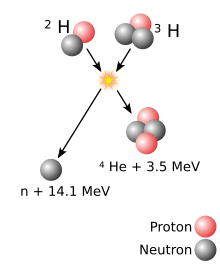

En 1918, Rutherford logró partir el núcleo del átomo al bombardear gas nitrógeno con partículas alfa, y observó que el gas emitía núcleos de hidrógeno. Rutherford concluyó que los núcleos de hidrógeno procedían de los núcleos de los mismos átomos de nitrógeno.15 Más tarde descubrió que la carga positiva de cualquier átomo equivalía siempre a un número entero de núcleos de hidrógeno. Esto, junto con el hecho de que el hidrógeno —el elemento más ligero— tenía una masa atómica de 1, le llevó a afirmar que los núcleos de hidrógeno eran partículas singulares, constituyentes básicos de todos los núcleos atómicos: se había descubierto el protón. Un experimento posterior de Rutherford mostró que la masa nuclear de la mayoría de los átomos superaba a la de los protones que tenía. Por tanto, postuló la existencia de partículas sin carga, hasta entonces desconocidas más tarde llamadas neutrones, de donde provendría este exceso de masa.

En 1928, Walther Bothe observó que el berilio emitía una radiación eléctricamente neutra cuando se le bombardeaba con partículas alfa. En 1932, James Chadwick expuso diversos elementos a esta radiación y dedujo que esta estaba compuesta por partículas eléctricamente neutras con una masa similar la de un protón.16 Chadwick llamó a estas partículas "neutrones".

Modelos cuánticos del átomo[editar]

El modelo planetario del átomo tenía sus defectos. En primer lugar, según la fórmula de Larmor del electromagnetismo clásico, una carga eléctrica en aceleración emite ondas electromagnéticas, y una carga en órbita iría perdiendo energía y describiría una espiral hasta acabar cayendo en el núcleo. Otro fenómeno que el modelo no explicaba era por qué los átomos excitados solo emiten luz con ciertos espectros discretos.

La teoría cuántica revolucionó la física de comienzos del siglo XX, cuando Max Planck y Albert Einstein postularon que se emite o absorbe una leve cantidad de energía en cantidades fijas llamadas cuantos. En 1913, Niels Bohr incorporó esta idea a su modelo atómico, en el que los electrones solo podrían orbitar alrededor del núcleo en órbitas circulares determinadas, con una energía y unmomento angular fijos, y siendo proporcionales las distancias del núcleo a los respectivos niveles de energía.17 Según este modelo, los átomos no podrían describir espirales hacia el núcleo porque no podrían perder energía de manera continua; en cambio, solo podrían realizar "saltos cuánticos" instantáneos entre los niveles fijos de energía.18 Cuando esto ocurre, el átomo absorbe o emite luz a una frecuencia proporcional a la diferencia de energía (y de ahí la absorción y emisión de luz en los espectros discretos).18 Arnold Sommerfeld amplió el átomo de Bohr en 1916 para incluir órbitas elípticas, utilizando una cuantificación de momento generalizado.

El modelo de Bohr-Sommerfeld ad hoc era muy difícil de utilizar, pero a cambio hacía increíbles predicciones de acuerdo con ciertas propiedades espectrales. Sin embargo, era incapaz de explicar los átomos multielectrónicos, predecir la tasa de transición o describir las estructuras finas e hiperfinas.

En 1924, Louis de Broglie propuso que todos los objetos —particularmente las partículas subatómicas, como los electrones— podían tener propiedades de ondas. Erwin Schrödinger, fascinado por esta idea, investigó si el movimiento de un electrón en un átomo se podría explicar mejor como onda que como partícula. La ecuación de Schrödinger, publicada en 1926,19 describe al electrón como una función de onda en lugar de como una partícula, y predijo muchos de los fenómenos espectrales que el modelo de Bohr no podía explicar. Aunque este concepto era matemáticamente correcto, era difícil de visualizar, y tuvo sus detractores.20 Uno de sus críticos,Max Born, dijo que la función de onda de Schrödinger no describía el electrón, pero sí a muchos de sus posibles estados, y de esta forma se podría usar para calcular la probabilidad de encontrar un electrón en cualquier posición dada alrededor del núcleo.21

En 1927, Werner Heisenberg indicó que, puesto que una función de onda está determinada por el tiempo y la posición, es imposible obtener simultáneamente valores precisos tanto para la posición como para el momento de la partícula para cualquier punto dado en el tiempo.22 Este principio fue conocido como principio de incertidumbre de Heisenberg.

Este nuevo enfoque invalidaba por completo el modelo de Bohr, con sus órbitas circulares claramente definidas. El modelo moderno del átomo describe las posiciones de los electrones en un átomo en términos de probabilidades. Un electrón se puede encontrar potencialmente a cualquier distancia del núcleo, pero —dependiendo de su nivel de energía— tiende a estar con más frecuencia en ciertas regiones alrededor del núcleo que en otras; estas zonas son conocidas como orbitales atómicos.

Importancia[editar]

La importancia de esta teoría no puede ser exagerada. Se ha dicho (por ejemplo el premio NobelRichard Feynman) que la teoría atómica es la teoría más importante en la historia de la ciencia. Esto se debe a las implicaciones que ha tenido, tanto para la ciencia básica como por las aplicaciones que se han derivado de ella.

Toda la química y bioquímica modernas se basan en la teoría de que la materia está compuesta de átomos de diferentes elementos, que no pueden transmutarse por métodos químicos. Por su parte, la química ha permitido el desarrollo de la industria farmacéutica, petroquímica, de abonos, el desarrollo de nuevos materiales, incluidos lossemiconductores, y otros avances.

CONTENIDO

- HISTORIA DE LA TEORIA ATOMICA 4

- TEORIA ATOMICA 5

- TEORIA ATOMICA DE DALTON 6

- MODELOS ATOMICOS 8

El Modelo de Thomson 8

El Modelo de Rutherford 8

Modelo Atómico de Niels Bohr 13

Modelo Cuántico (Actual) 15

- BIBLIOGRAFIA 20

HISTORIA DE LA TEORIA ATOMICA

Cinco siglos antes de Cristo, los filósofos griegos se preguntaban si la materia podía ser dividida indefinidamente o si llegaría a un punto, que tales partículas, fueran indivisibles. Es así, como Demócrito formula la teoría de que la materia se compone de partículas indivisibles, a las que llamó átomos (del griego átomos, indivisible).

En 1803 el químico inglés John Dalton propone una nueva teoría sobre la constitución de la materia. Según Dalton toda la materia se podía dividir en dos grandes grupos: los elementos y los compuestos. Los elementos estarían constituidos por unidades fundamentales, que en honor a Demócrito, Dalton denominó átomos. Los compuestos se constituirían de moléculas, cuya estructura viene dada por la unión de átomos en proporciones definidas y constantes. La teoría de Dalton seguía considerando el hecho de que los átomos eran partículas indivisibles.

Hacia finales del siglo XIX, se descubrió que los átomos no son indivisibles, pues se componen de varios tipos de partículas elementales. La primera en ser descubierta fue el electrón en el año 1897 por el investigador Sir Joseph Thomson, quién recibió el Premio Nobel de Física en 1906. Posteriormente, Hantaro Nagaoka (1865-1950) durante sus trabajos realizados en Tokio, propone su teoría según la cual los electrones girarían en órbitas alrededor de un cuerpo central cargado positivamente, al igual que los planetas alrededor del Sol. Hoy día sabemos que la carga positiva del átomo se concentra en un denso núcleo muy pequeño, en cuyo alrededor giran los electrones.

El núcleo del átomo se descubre gracias a los trabajos realizados en la Universidad de Manchester, bajo la dirección de Ernest Rutherford entre los años 1909 a 1911. El experimento utilizado consistía en dirigir un haz de partículas de cierta energía contra una plancha metálica delgada, de las probabilidades que tal barrera desviara la trayectoria de las partículas, se dedujo la distribución de la carga eléctrica al interior de los átomos.

TEORIA ATOMICA

La descripción básica de la constitución atómica, reconoce la existencia de partículas con carga eléctrica negativa, llamados electrones, los cuales giran en diversas órbitas (niveles de energía) alrededor de un núcleo central con carga eléctrica positiva. El átomo en su conjunto y sin la presencia de perturbaciones externas es eléctricamente neutro.

El núcleo lo componen los protones con carga eléctrica positiva, y los neutrones que no poseen carga eléctrica.

El tamaño de los núcleos atómicos para los diversos elementos están comprendidos entre una cien milésima y una diez milésima del tamaño del átomo.

La cantidad de protones y de electrones presentes en cada átomo es la misma. Esta cantidad recibe el nombre de número atómico, y se designa por la letra "Z". A la cantidad total de protones más neutrones presentes en un núcleo atómico se le llama número másico y se designa por la letra "A".

Si designamos por "X" a un elemento químico cualquiera, su número atómico y másico se representa por la siguiente simbología:

ZXA

Por ejemplo, para el Hidrogeno tenemos: 1H1.

Si bien, todas las características anteriores de la constitución atómica, hoy en día son bastante conocidas y aceptadas, a través de la historia han surgido diversos módelos que han intentado dar respuesta sobre la estructura del átomo.

TEORÍA ATÓMICA DE DALTON

Aproximadamente por el año 1808, define a los átomos como la unidad constitutiva de los elementos (retomando las ideas de los atomistas griegos). Las ideas básicas de su teoría, publicadas en 1808 y 1810 pueden resumirse en los siguientes puntos:

- La materia está formada por partículas muy pequeñas para ser vistas, llamadas átomos.

- Los átomos de un elemento son idénticos en todas sus propiedades, incluyendo el peso.

- Diferentes elementos están formados por diferentes átomos.

- Los compuestos químicos se forman de la combinación de átomos de dos o más elementos, en un átomo compuesto; o lo que es lo mismo, un compuesto químico es el resultado de la combinación de átomos de dos o más elementos en una proporción numérica simple.

- Los átomos son indivisibles y conservan sus características durante las reacciones químicas.

- En cualquier reacción química, los átomos se combinan en proporciones numéricas simples.

- La separación de átomos y la unión se realiza en las reacciones químicas. En estas reacciones, ningún átomo se crea o destruye y ningún átomo de un elemento se convierte en un átomo de otro elemento.

A pesar de que la teoría de Dalton era errónea en varios aspectos, significó un avance cualitativo importante en el camino de la comprensión de la estructura de la materia. Por supuesto que la aceptación del modelo de Dalton no fue inmediata, muchos científicos se resistieron durante muchos años a reconocer la existencia de dichas partículas.

Además de sus postulados Dalton empleó diferentes símbolos para representar los átomos y los átomos compuestos, las moléculas.

Sin embargo, Dalton no elabora ninguna hipótesis acerca de la estructura de los átomos y habría que esperar casi un siglo para que alguien expusiera una teoría acerca de la misma.

Otras Leyes que concordaban con la teoría de Dalton:

- Ley de la Conservación de la Masa: La Materia no se crea ni se destruye, sólo se transforma.

- Ley de las Proporciones Definidas: Un Compuesto Puro siempre contiene los mismos elementos combinados en las mismas proporciones en masa.

- Ley de las Proporciones Múltiples: Cuando dos elementos A y B forman más de un compuesto, las cantidades de A que se combinan en estos compuestos, con una cantidad fija de B, están en relación de números pequeños enteros.

MODELOS ATOMICOS

El Modelo de Thomson.

Thomson sugiere un modelo atómico que tomaba en cuenta la existencia del electrón, descubierto por él en 1897. Su modelo era estático, pues suponía que los electrones estaban en reposo dentro del átomo y que el conjunto era eléctricamente neutro. Con este modelo se podían explicar una gran cantidad de fenómenos atómicos conocidos hasta la fecha. Posteriormente, el descubrimiento de nuevas partículas y los experimentos llevado a cabo por Rutherford demostraron la inexactitud de tales ideas.

Para explicar la formación de iones, positivos y negativos, y la presencia de los electrones dentro de la estructura atómica, Thomson ideó un átomo parecido a un pastel de frutas (Figura N° 01).

Figura N° 01

Una nube positiva que contenía las pequeñas partículas negativas (los electrones) suspendidos en ella. El número de cargas negativas era el adecuado para neutralizar la carga positiva.

En el caso de que el átomo perdiera un electrón, la estructura quedaría positiva; y si ganaba, la carga final sería negativa. De esta forma, explicaba la formación de iones; pero dejó sin explicación la existencia de las otras radiaciones.

El Modelo de Ernest Rutherford.

Basado en los resultados de su trabajo, que demostró la existencia del núcleo atómico, Rutherford sostiene que casi la totalidad de la masa del átomo se concentra en un núcleo central muy diminuto de carga eléctrica positiva. Los electrones giran alrededor del núcleo describiendo órbitas circulares. Estos poseen una masa muy ínfima y tienen carga eléctrica negativa. La carga eléctrica del núcleo y de los electrones se neutralizan entre sí, provocando que el átomo sea eléctricamente neutro.

El modelo de Rutherford tuvo que ser abandonado, pues el movimiento de los electrones suponía una pérdida continua de energía, por lo tanto, el electrón terminaría describiendo órbitas en espiral, precipitándose finalmente hacia el núcleo. Sin embargo, este modelo sirvió de base para el modelo propuesto por su discípulo Neils Bohr, marcando el inicio del estudio del núcleo atómico, por lo que a Rutherford se le conoce como el padre de la era nuclear.

Ernest Rutherford estudió los componentes de la radiación que ocurre espontáneamente en la Naturaleza. A continuación se presenta una tabla resumiendo las características de estos componentes:

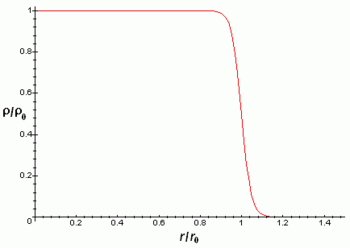

Fue Erwin Schodinger, quien ideó el modelo atómico actual, llamado "Ecuación de Onda", una fórmula matemática que considera los aspectos anteriores. La solución de esta ecuación, es la función de onda (PSI), y es una medida de la probabilidad de encontrar al electrón en el espacio. En este modelo, el área donde hay mayor probabilidad de encontrar al electrón se denomina orbital.

El valor de la función de onda

asociada con una partícula en movimiento esta relacionada con la probabilidad de encontrar a la partícula en el punto (x,y,z) en el instante de tiempo t.

asociada con una partícula en movimiento esta relacionada con la probabilidad de encontrar a la partícula en el punto (x,y,z) en el instante de tiempo t.

En general una onda puede tomar valores positivos y negativos. Por ejemplo la onda:

En general una onda puede representarse por medio de una cantidad compleja:

Piense por ejemplo en el campo eléctrico de una onda electromagnética. Una probabilidad negativa, o compleja, es algo sin sentido. Esto significa que la función de onda no es algo observable. Sin embargo el módulo (o cuadrado) de la función de onda siempre es real y positivo. Por esto, a

se le conoce como la densidad de probabilidad.

se le conoce como la densidad de probabilidad.

Ahora sí podemos dar una interpretación física:

Nubes de probabilidad electrónicas:

En el caso más general de una función de onda compleja

el cuadrado esta dado por:

La función de onda depende de los valores de tres (03) variables que reciben la denominación de números cuánticos. Cada conjunto de números cuánticos, definen una función específica para un electrón.

Números Cuánticos:

Son cuatro (04) los números encargados de definir la función de onda (PSI) asociada a cada electrón de un átomo: el principal, secundario, magnético y de Spin. Los tres (03) primeros resultan de la ecuación de onda; y el último, de las observaciones realizadas de los campos magnéticos generados por el mismo átomo.

Número cuántico principal

Es un criterio positivo, representado por la letra "n", indica los niveles energéticos principales. Se encuentra relacionado con el tamaño. En la medida que su valor aumenta, el nivel ocupa un volumen mayor y puede contener más electrones, y su contenido energético es superior. Sus valores pueden ser desde 1 hasta infinito.

Número cuántico secundario

Representado por la letra "I", nos indica la forma que pueden tener el espacio donde se encuentra el electrón. El valor que se le asigna depende del número principal; va desde cero (0) hasta n-1.

Se ha conseguido que para dos (02)

Equipo 2:

Teoría de la relatividad

La teoría de la relatividad incluye tanto a la teoría de la relatividad especial como la de relatividad general, formuladas por Albert Einstein a principios del siglo XX, que pretendían resolver la incompatibilidad existente entre la mecánica newtoniana y elelectromagnetismo.

La teoría de la relatividad especial, publicada en 1905, trata de la física del movimiento de los cuerpos en ausencia de fuerzasgravitatorias, en el que se hacían compatibles las ecuaciones de Maxwell del electromagnetismo con una reformulación de las leyes del movimiento.

La teoría de la relatividad general, publicada en 1915, es una teoría de la gravedad que reemplaza a la gravedad newtoniana, aunque coincide numéricamente con ella para campos gravitatorios débiles y "pequeñas" velocidades. La teoría general se reduce a la teoría especial en ausencia de campos gravitatorios.

Conceptos principales[editar]

El supuesto básico de la teoría de la relatividad es que la localización de los sucesos físicos, tanto en el tiempo como en el espacio, son relativos al estado de movimiento delobservador: así, la longitud de un objeto en movimiento o el instante en que algo sucede, a diferencia de lo que sucede en mecánica newtoniana, no son invariantes absolutos, y diferentes observadores en movimiento relativo entre sí diferirán respecto a ellos (las longitudes y los intervalos temporales, en relatividad son relativos y no absolutos).

Relatividad especial[editar]

La teoría de la relatividad especial, también llamada teoría de la relatividad restringida, fue publicada por Albert Einstein en 1905 y describe la física del movimiento en el marco de un espacio-tiempo plano. Esta teoría describe correctamente el movimiento de los cuerpos incluso a grandes velocidades y sus interacciones electromagnéticas, se usa básicamente para estudiar sistemas de referencia inerciales (no es aplicable para problemas astrofísicos donde el campo gravitatorio desempeña un papel importante).

Estos conceptos fueron presentados anteriormente por Poincaré y Lorentz, que son considerados como precursores de la teoría. Si bien la teoría resolvía un buen número de problemas del electromagnetismo y daba una explicación del experimento de Michelson-Morley, no proporciona una descripción relativista adecuada del campo gravitatorio.

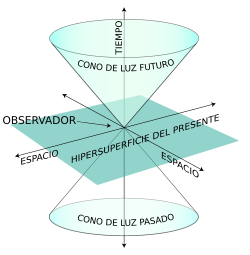

Tras la publicación del artículo de Einstein, la nueva teoría de la relatividad especial fue aceptada en unos pocos años por la práctica totalidad de los físicos y los matemáticos. De hecho, Poincaré o Lorentz habían estado muy cerca de llegar al mismo resultado que Einstein. La forma geométrica definitiva de la teoría se debe a Hermann Minkowski, antiguo profesor de Einstein en la Politécnica de Zürich; acuñó el término "espacio-tiempo" (Raumzeit) y le dio la forma matemática adecuada.nota 1 El espacio-tiempo de Minkowski es una variedad tetradimensional en la que se entrelazaban de una manera insoluble las tres dimensiones espaciales y el tiempo. En este espacio-tiempo de Minkowski, el movimiento de una partícula se representa mediante su línea de universo (Weltlinie), una curva cuyos puntos vienen determinados por cuatro variables distintas: las tres dimensiones espaciales (,,) y el tiempo (). El nuevo esquema de Minkowski obligó a reinterpretar los conceptos de la métrica existentes hasta entonces. El concepto tridimensional de punto fue sustituido por el de suceso. La magnitud de distancia se reemplaza por la magnitud de intervalo.

Relatividad general[editar]

La relatividad general fue publicada por Einstein en 1915, presentada como conferencia en la Academia de Ciencias Prusiana el 25 de noviembre. La teoría generaliza el principio de relatividad de Einstein para un observador arbitrario. Esto implica que las ecuaciones de la teoría deben tener una forma de covariancia más general que la covariancia de Lorentz usada en la teoría de la relatividad especial. Además de esto, la teoría de la relatividad general propone que la propia geometría del espacio-tiempo se ve afectada por la presencia de materia, de lo cual resulta una teoría relativista del campo gravitatorio. De hecho la teoría de la relatividad general predice que el espacio-tiempo no será plano en presencia de materia y que la curvatura del espacio-tiempo será percibida como un campo gravitatorio.

Debe notarse que el matemático alemán David Hilbert escribió e hizo públicas las ecuaciones de la covarianza antes que Einstein. Ello resultó en no pocas acusaciones de plagio contra Einstein, pero probablemente sea más, porque es una teoría (o perspectiva) geométrica. La misma postula que la presencia de masa o energía «curva» al espacio-tiempo, y esta curvatura afecta la trayectoria de los cuerpos móviles e incluso la trayectoria de la luz.

Einstein expresó el propósito de la teoría de la relatividad general para aplicar plenamente el programa de Ernst Mach de la relativización de todos los efectos de inercia, incluso añadiendo la llamada constante cosmológica a sus ecuaciones de campo4 para este propósito. Este punto de contacto real de la influencia de Ernst Mach fue claramente identificado en 1918, cuando Einstein distingue lo que él bautizó como el principio de Mach (los efectos inerciales se derivan de la interacción de los cuerpos) del principio de la relatividad general, que se interpreta ahora como el principio de covarianza general.5

Formalismo de la teoría de la relatividad[editar]

Partículas[editar]

En la teoría de la relatividad una partícula puntual queda representada por un par , donde es una curva diferenciable, llamada línea de universo de la partícula, y m es un escalar que representa la masa en reposo. El vector tangente a esta curva es un vector temporal llamado cuadrivelocidad, el producto de este vector por la masa en reposo de la partícula es precisamente el cuadrimomento. Este cuadrimomento es un vector de cuatro componentes, tres de estas componentes se denominan espaciales y representan el análogo relativista del momento lineal de la mecánica clásica, la otra componente denominada componente temporal representa la generalización relativista de la energía cinética. Además, dada una curva arbitraria en el espacio-tiempo, puede definirse a lo largo de ella el llamado intervalo relativista, que se obtiene a partir del tensor métrico. El intervalo relativista medido a lo largo de la trayectoria de una partícula es proporcional al intervalo de tiempo propio o intervalo de tiempo percibido por dicha partícula.

Campos[editar]